油藏计算是一种基于循环神经网络(RNN)的有前景的计算框架,它本质上将输入数据映射到高维计算空间,保持人工神经网络(ANN)的一些参数固定,同时更新其他参数。该框架可以帮助提高机器学习算法的性能,同时还可以减少充分训练算法所需的数据量。

RNN本质上利用不同处理单元之间的循环连接来处理顺序数据并做出准确的预测。虽然RNN被发现在许多任务上表现良好,但通过识别与要处理的任务最相关的参数来优化其性能可能具有挑战性且耗时。

宾夕法尼亚大学的两名研究人员JasonKim和DaniS.Bassett最近引入了一种替代方法来设计和编程基于RNN的储层计算机,该方法的灵感来自于编程语言在计算机硬件上的工作方式。这种方法发表在《自然机器智能》上,可以识别给定网络的适当参数,对其计算进行编程以优化其在目标问题上的性能。

“无论是计算小费还是模拟国际象棋游戏中的多个动作,我们一直对大脑如何表示和处理信息感兴趣,”Kim告诉TechXplore。“循环神经网络(RNN)在大脑动力学建模和学习复杂计算方面取得的成功给我们带来了启发。借鉴这一灵感,我们提出了一个简单的问题:如果我们能够像计算机一样对RNN进行编程,结果会怎样?控制理论、动力系统和物理学方面的工作告诉我们,这不是一个不可能实现的梦想。”

Kim和Bassett提出的神经机器代码是通过反编译RNN的内部表示和动态来指导他们对输入数据的分析。他们的方法类似于在计算机硬件上编译算法的过程,其中需要详细说明各个晶体管需要打开和关闭的位置和时间。

“在RNN中,这些操作在分布在网络中的权重中同时指定,并且神经元都并行运行操作并存储内存,”Kim解释道。“我们使用数学来定义将运行所需算法(例如,求解方程、模拟视频游戏)的操作集(连接权重),并提取在现有权重集上运行的算法。我们方法的独特优势在于,它不需要数据或采样,并且它不仅定义了一种连接,还定义了运行所需算法的连接模式空间。”

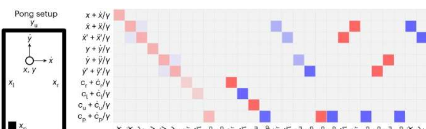

研究人员通过使用其框架为各种应用开发RNN来展示其框架的优势,包括虚拟机、逻辑门和人工智能支持的乒乓球视频游戏。人们发现这些算法都表现得非常好,不需要对其参数进行反复试验调整。

Kim说:“我们工作的一个显着贡献是我们理解和研究RNN的方式从数据处理工具到成熟的计算机的范式转变。”“这种转变意味着我们可以检查经过训练的RNN并了解它正在解决什么问题,并且我们可以设计RNN来执行任务,而无需训练数据或反向传播。实际上,我们可以使用假设驱动的算法而不是随机权重来初始化我们的网络或者预训练的RNN,我们可以直接从RNN中提取学习模型。”

该研究团队引入的编程框架和神经机器代码很快就会被其他团队用来设计性能更好的RNN并轻松调整其参数。Kim和Bassett最终希望最终使用他们的框架来创建在神经形态硬件上运行的成熟软件。在接下来的研究中,他们还计划设计一种方法来提取经过训练的水库计算机学习的算法。

“虽然神经网络在处理复杂和高维数据方面表现出色,但这些网络的运行往往需要消耗大量能量,并且理解它们所学到的东西非常具有挑战性,”金说。“我们的工作为直接反编译训练后的权重并将其转换为显式算法提供了一个垫脚石,该算法可以在不需要RNN的情况下更有效地运行,并进一步审查科学理解和性能。”

宾夕法尼亚大学巴塞特的研究小组也在致力于使用机器学习方法,特别是RNN,来重现人类的心理过程和能力。他们最近创建的神经机器代码可以支持他们在这一研究领域的努力。

“第二个令人兴奋的研究方向是设计RNN来执行人类认知功能特征的任务,”监督该研究的教授DaniS.Bassett补充道。“使用认知过程的理论、模型或数据衍生的定义,我们设想设计RNN来参与注意力、本体感觉和好奇心。在这样做时,我们渴望了解支持这种独特认知过程的连接配置文件。”